京公网安备 11010802034615号

经营许可证编号:京B2-20210330

京公网安备 11010802034615号

经营许可证编号:京B2-20210330

cd /opt/linuxsir

tar -zxvf hadoop-2.7.3.tar.gz

ls

mv hadoop-2.7.3 /opt/linuxsir/hadoop

在192.168.31.131虚拟机上编辑/root/.bashrc文件,然后复制到192.168.31.132、192.168.31.133

echo "" >> /root/.bashrc

echo "export HADOOP_PREFIX=/opt/linuxsir/hadoop" >> /root/.bashrc

echo "export HADOOP_HOME=$HADOOP_PREFIX" >> /root/.bashrc

echo "export HADOOP_COMMON_HOME=$HADOOP_PREFIX" >> /root/.bashrc

echo "export HADOOP_CONF_DIR=$HADOOP_PREFIX/etc/hadoop" >> /root/.bashrc

echo "export HADOOP_HDFS_HOME=$HADOOP_PREFIX" >> /root/.bashrc

echo "export HADOOP_MAPRED_HOME=$HADOOP_PREFIX" >> /root/.bashrc

echo "export HADOOP_YARN_HOME=$HADOOP_PREFIX" >> /root/.bashrc

echo "export PATH=$PATH:$HADOOP_PREFIX/sbin:$HADOOP_PREFIX/bin" >> /root/.bashrc

echo "export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib/native"" >> /root/.bashrc

echo "export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native" >> /root/.bashrc

echo "export CLASSPATH=$CLASSPATH:/opt/linuxsir/hadoop/lib/*" >> /root/.bashrc

cat /root/.bashrc

\在192.168.31.131上,复制/root/.bashrc到132和133

scp -r /root/.bashrc root@192.168.31.132:/root/.bashrc

scp -r /root/.bashrc root@192.168.31.133:/root/.bashrc

\在192.168.31.131上,在131/132/133三台机器上运行/root/.bashrc,刷新环境

cd

source /root/.bashrc

ssh root@192.168.31.132 source /root/.bashrc

ssh root@192.168.31.133 source /root/.bashrc

cd /opt/linuxsir/hadoop \进入/opt/linuxsir/hadoop目录

rm -rf /opt/linuxsir/hadoop/tmp

rm -rf /opt/linuxsir/hadoop/hdfs

mkdir /opt/linuxsir/hadoop/tmp \创建tmp目录

mkdir -p /opt/linuxsir/hadoop/hdfs/data /opt/linuxsir/hadoop/hdfs/name \创建hdfs的data、name子目录

\还要针对hd-slave1,hd-slave2等两个节点上执行上述命令,然后再初始化hdfs

ssh root@192.168.31.132 rm -rf /opt/linuxsir/hadoop/tmp

ssh root@192.168.31.132 rm -rf /opt/linuxsir/hadoop/hdfs

ssh root@192.168.31.132 mkdir /opt/linuxsir/hadoop/tmp

ssh root@192.168.31.132 mkdir -p /opt/linuxsir/hadoop/hdfs/data /opt/linuxsir/hadoop/hdfs/name

ssh root@192.168.31.133 rm -rf /opt/linuxsir/hadoop/tmp

ssh root@192.168.31.133 rm -rf /opt/linuxsir/hadoop/hdfs

ssh root@192.168.31.133 mkdir /opt/linuxsir/hadoop/tmp

ssh root@192.168.31.133 mkdir -p /opt/linuxsir/hadoop/hdfs/data /opt/linuxsir/hadoop/hdfs/name

对若干配置文件进行设置,保证Hadoop能够正常启动。

(1) 主要的配置文件包括HADOOP_HOME目录下的

(2) 并且为如下文件配置环境变量

(3)master和slave

编辑/opt/linuxsir/hadoop/etc/hadoop目录下的core-site.xml文件

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:///opt/linuxsir/hadoop/tmp</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hd-master:9000</value><!-- NameNode URI -->

</property>

<property>

<name>io.file.buffer.size</name>

<value>131702</value>

</property>

</configuration>

编辑/opt/linuxsir/hadoop/etc/hadoop目录下的hdfs-site.xml文件,内容如下

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///opt/linuxsir/hadoop/hdfs/name</value> <!-- 本机name目录for NameNode -->

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///opt/linuxsir/hadoop/hdfs/data</value> <!-- 本机data目录for DataNode -->

</property>

<property>

<name>dfs.replication</name> <!-- 数据块副本数量 -->

<value>2</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hd-master:9001</value>

</property>

</configuration>

在/opt/linuxsir/hadoop/etc/hadoop目录下,复制mapred-site.xml.template到mapred-site.xml,并且进行编辑

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value> <!--yarn or yarn-tez-->

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>hd-master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hd-master:19888</value>

</property>

<property>

<name>mapreduce.map.memory.mb</name> <!-- memory for map task -->

<value>64</value>

</property>

<property>

<name>mapreduce.reduce.memory.mb</name> <!-- memory for reduce task -->

<value>128</value>

</property>

<property>

<name>mapreduce.task.io.sort.mb</name>

<value>32</value>

</property>

<property>

<name>mapreduce.map.java.opts</name> <!-- settings for JVM map task -->

<value>-Xms128m -Xmx256m</value>

</property>

<property>

<name>mapreduce.reduce.java.opts</name> <!-- settings for JVM reduce task -->

<value>-Xms128m -Xmx256m</value>

</property>

</configuration>

在/opt/linuxsir/hadoop/etc/hadoop编辑yarn-site.xml文件,对YARN资源管理器的ResourceManager和NodeManagers节点、端口、内存分配等进行配置

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hd-master</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>hd-master:9032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>hd-master:9030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>hd-master:9031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>hd-master:9033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>hd-master:9099</value>

</property>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>2048</value>

</property>

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>2048</value>

</property>

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>1024</value>

</property>

<property>

<name>yarn.app.mapreduce.am.resource.mb</name>

<value>1024</value>

</property>

<property>

<name>yarn.app.mapreduce.am.command-opts</name>

<value>-Xms128m -Xmx256m</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.vmem-pmem-ratio</name>

<value>8</value>

</property>

<property>

<name>yarn.nodemanager.resource.cpu-vcores</name>

<value>1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

进入hadoop-env.sh脚本文件所在目录/opt/linuxsir/hadoop/etc/Hadoop

export JAVA_HOME=/opt/linuxsir/java/jdk

接着,设置/opt/linuxsir/hadoop/etc/hadoop目录下yarn-env.sh脚本文件的JAVA_HOME变量,内容如下

export JAVA_HOME=/opt/linuxsir/java/jdk

如果NodeManager因为内存不足,而启动不起来,那么yarn-env.sh文件需要做如下修改,即JAVA_HEAP_MAX改为3G

JAVA_HEAP_MAX=-Xmx3072m

修改/opt/linuxsir/hadoop/etc/hadoop/masters文件和/opt/linuxsir/hadoop/etc/hadoop/slaves文件,目的是指定主节点和从节点列表。

/opt/linuxsir/hadoop/etc/hadoop/masters文件的内容如下,即主节点为hd-master

hd-master

/opt/linuxsir/hadoop/etc/hadoop/slaves文件的内容如下,即从节点为hd-slave1和hd-slave2

hd-slave1

hd-slave2

从192.168.31.131虚拟机复制Hadoop到其它各个节点,包括192.168.31.132、192.168.31.133。 在192.168.31.131上运行如下命令

chmod a+rwx -R /opt/linuxsir \设置/opt/linuxsir的存取权限

ssh root@192.168.31.132 chmod a+rwx -R /opt/linuxsir

ssh root@192.168.31.133 chmod a+rwx -R /opt/linuxsir

scp -r /root/.bashrc root@192.168.31.132:/root/.bashrc \复制/root/.bashrc

scp -r /root/.bashrc root@192.168.31.133:/root/.bashrc

scp -r /opt/linuxsir/hadoop hd-slave1:/opt/linuxsir \复制/opt/linuxsir/hadoop

scp -r /opt/linuxsir/hadoop hd-slave2:/opt/linuxsir

source ~/.bashrc \刷新环境变量

ssh root@192.168.31.132 source ~/.bashrc

ssh root@192.168.31.133 source ~/.bashrc

这里分享一个你一定用得到的小程序——CDA数据分析师考试小程序。

它是专为CDA数据分析认证考试报考打造的一款小程序。可以帮你快速报名考试、查成绩、查证书、查积分,通过该小程序,考生可以享受更便捷的服务。

扫码加入CDA小程序,与圈内考生一同学习、交流、进步!

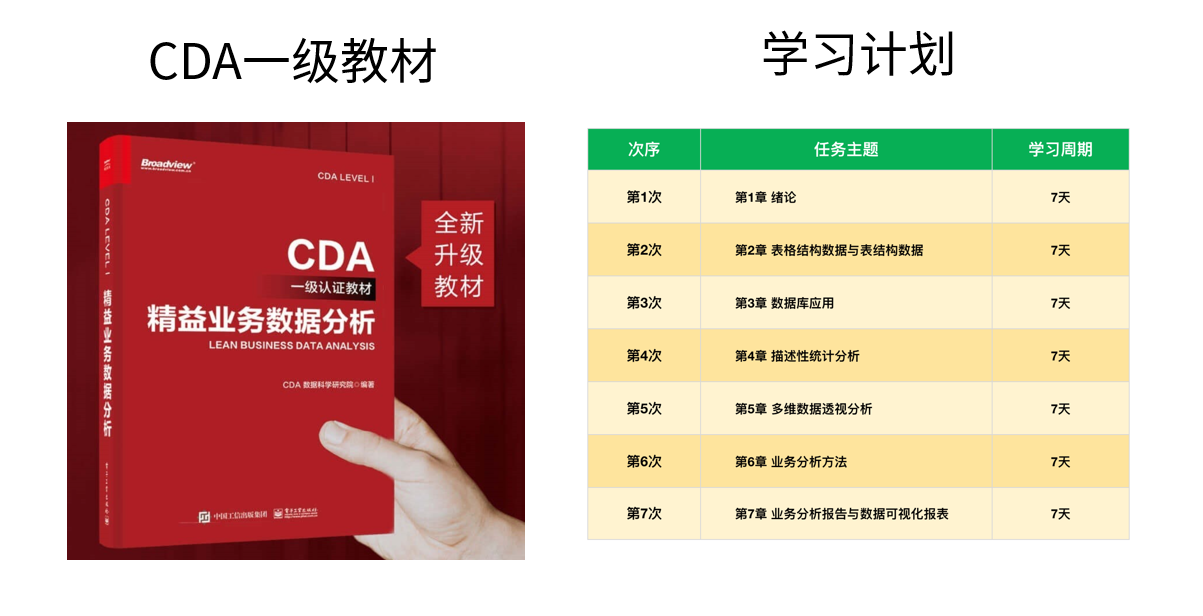

《CDA一级教材》适合CDA一级考生备考,也适合业务及数据分析岗位的从业者提升自我。完整电子版已上线CDA网校,累计已有10万+在读~

免费加入阅读:https://edu.cda.cn/goods/show/3151?targetId=5147&preview=0

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

在金融行业的数字化转型进程中,SQL作为数据处理与分析的核心工具,贯穿于零售银行、证券交易、保险理赔、支付结算等全业务链条 ...

2025-12-24在数据分析领域,假设检验是验证“数据差异是否显著”的核心工具,而独立样本t检验与卡方检验则是其中最常用的两种方法。很多初 ...

2025-12-24在企业数字化转型的深水区,数据已成为核心生产要素,而“让数据可用、好用”则是挖掘数据价值的前提。对CDA(Certified Data An ...

2025-12-24数据分析师认证考试全面升级后,除了考试场次和报名时间,小伙伴们最关心的就是报名费了,报 ...

2025-12-23CDA中国官网是全国统一的数据分析师认证报名网站,由认证考试委员会与持证人会员、企业会员以及行业知名第三方机构共同合作,致 ...

2025-12-23在Power BI数据可视化分析中,矩阵是多维度数据汇总的核心工具,而“动态计算平均值”则是矩阵分析的高频需求——无论是按类别计 ...

2025-12-23在SQL数据分析场景中,“日期转期间”是高频核心需求——无论是按日、周、月、季度还是年度统计数据,都需要将原始的日期/时间字 ...

2025-12-23在数据驱动决策的浪潮中,CDA(Certified Data Analyst)数据分析师的核心价值,早已超越“整理数据、输出报表”的基础层面,转 ...

2025-12-23在使用Excel数据透视表进行数据分析时,我们常需要在透视表旁添加备注列,用于标注数据背景、异常说明、业务解读等关键信息。但 ...

2025-12-22在MySQL数据库的性能优化体系中,索引是提升查询效率的“核心武器”——一个合理的索引能将百万级数据的查询耗时从秒级压缩至毫 ...

2025-12-22在数据量爆炸式增长的数字化时代,企业数据呈现“来源杂、格式多、价值不均”的特点,不少CDA(Certified Data Analyst)数据分 ...

2025-12-22在企业数据化运营体系中,同比、环比分析是洞察业务趋势、评估运营效果的核心手段。同比(与上年同期对比)可消除季节性波动影响 ...

2025-12-19在数字化时代,用户已成为企业竞争的核心资产,而“理解用户”则是激活这一资产的关键。用户行为分析系统(User Behavior Analys ...

2025-12-19在数字化转型的深水区,企业对数据价值的挖掘不再局限于零散的分析项目,而是转向“体系化运营”——数据治理体系作为保障数据全 ...

2025-12-19在数据科学的工具箱中,析因分析(Factor Analysis, FA)、聚类分析(Clustering Analysis)与主成分分析(Principal Component ...

2025-12-18自2017年《Attention Is All You Need》一文问世以来,Transformer模型凭借自注意力机制的强大建模能力,在NLP、CV、语音等领域 ...

2025-12-18在CDA(Certified Data Analyst)数据分析师的时间序列分析工作中,常面临这样的困惑:某电商平台月度销售额增长20%,但增长是来 ...

2025-12-18在机器学习实践中,“超小数据集”(通常指样本量从几十到几百,远小于模型参数规模)是绕不开的场景——医疗领域的罕见病数据、 ...

2025-12-17数据仓库作为企业决策分析的“数据中枢”,其价值完全依赖于数据质量——若输入的是缺失、重复、不一致的“脏数据”,后续的建模 ...

2025-12-17在CDA(Certified Data Analyst)数据分析师的日常工作中,“随时间变化的数据”无处不在——零售企业的每日销售额、互联网平台 ...

2025-12-17