信用卡通不过?用数据分析技术,带你深度解析信用卡评分体系

随着互联网金融时代的到来,信用评分体系显得越发重要,本文就解读信用卡评分体系是如何建立的。

客户信息涉及到很多因素,因此许多因素无法在机器学习模型中进行探讨,这里收集了大部分互联网金融公司在信用卡申请时能获取到的信息。

目标

1. 使用机器学习构建信用卡评分模型,获得自变量分箱结果;

2. 并由评分模型得出最优的cutoff值,并对模型进行评价;

3. 再由新的样本集对评分卡进行测试,输出预测结果。

数据

我使用了Kaggle的两个数据集。

Kaggle数据集链接:

https://www.kaggle.com/yuzijuan/credit-card-scoring/data

环境和工具:

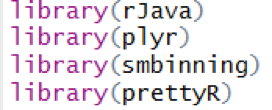

Rstudio,plyr,rJava,smbinning,prettyR

我首先对两个数据集进行探索性分析,剔除掉无法纳入模型的变量,例如ID,取值为空的变量,取值仅为一类的变量等;再探索配偶收入变量问题时,由于值绝大部分为0,将该变量变为二分类变量,取值为有收入与无收入;针对异常值过大的变量,采用盖帽法,用99分位点值代替极大异常值,有1分位点值代替极小异常值等等方法,数据清洗完后,再用smbinning包进行cart分箱,带入评分卡模型,获得评分卡,最后将其运用到测试集上。

开始

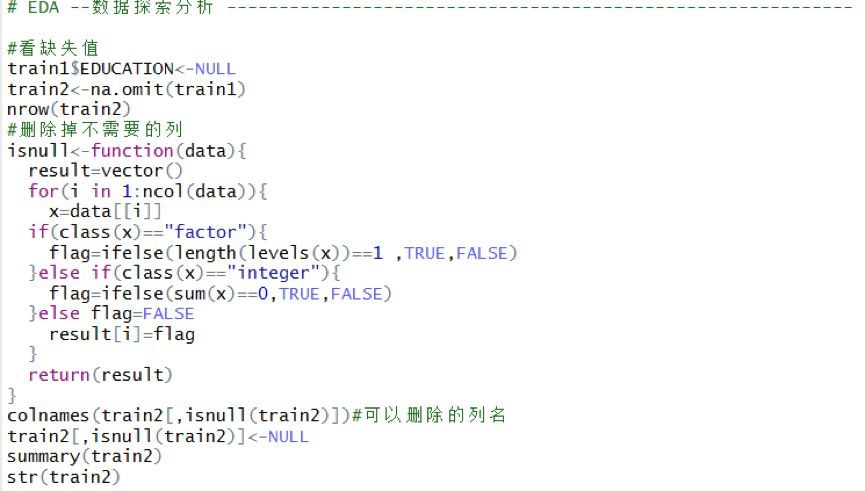

首先,导入必要的库和数据集,进行探索性数据分析,并剔除掉无法纳入模型的变量。

导入库

导入数据

![]()

剔除无法纳入模型的变量

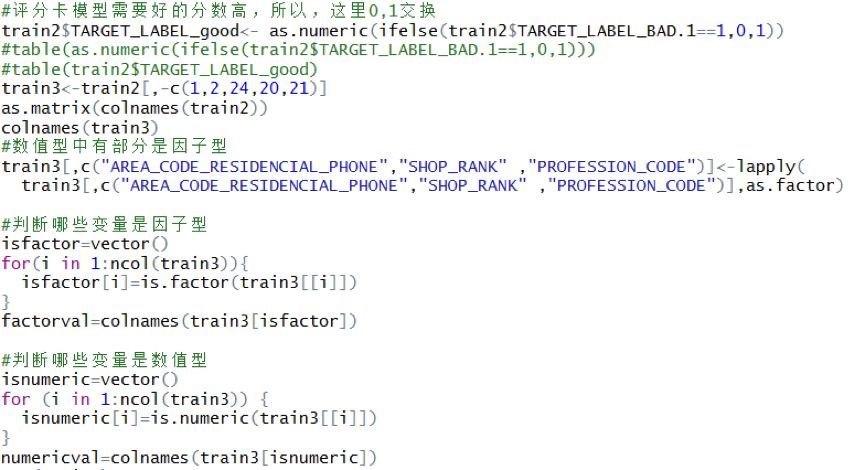

由于评分卡模型一般分数越高,表示信用越好,故需要将信用好的类别得分记为1,信用不好的类别得分记为0。

为更有效分箱,获取了因子型变量集factorval和数值型变量集numericval,分别进行分箱处理。

数值型变量分箱

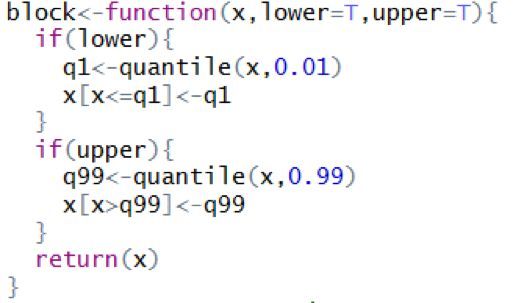

为更有效进行数据处理,对异常值可以进行盖帽法处理,代码如下:

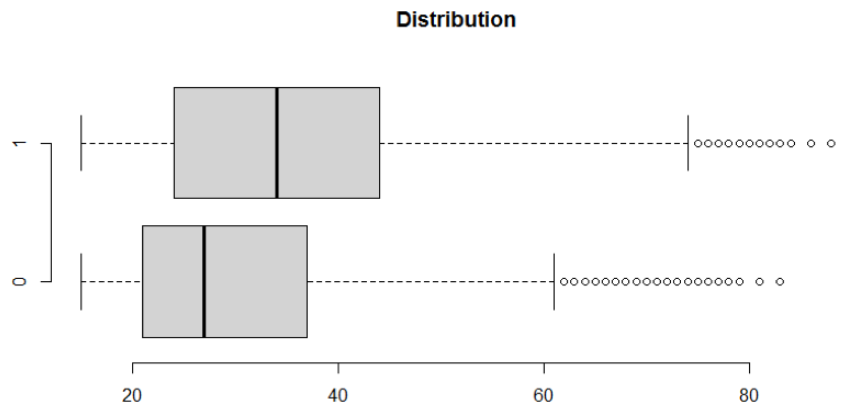

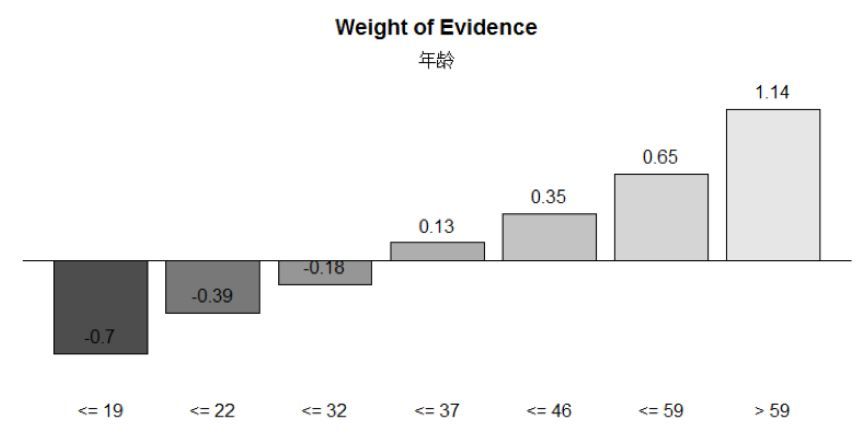

以年龄数值型变量举例说明,首先查看数据分布情况,由于是因变量为二分类,自变量为数值型,用t检验来检验两分布是否有显著性差别,有显著性差别才能进行分箱,否则分箱结果无意义。

分布情况如上图所示,可以对其进行盖帽法后再t检验和分箱处理。t检验的原假设为两分类组的均值相等,结果表明原假设被拒绝,认为两分布具有显著性差别,可以进行分箱。

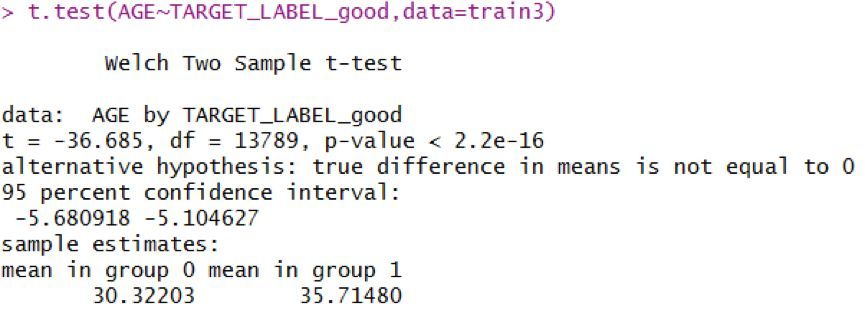

用的是smbinning包,这个包中采用的是CART回归树进行属性划分,数值型用函数smbinning(),由树的结果可知,划分点为19,22,32,37,46、59六个值,划分为7个属性区间。

AGE的IV值为0.2004,对AGE的WOE值画图,得到分布呈现单调趋势,表明分箱结果良好,可以纳入模型。

用AGE进行分箱的代码如下:

类推其他连续变量。通过调用numericalval可知共有7个数值型变量,由于两个数值型变量取值过于集中,后续将作为分类变量处理,故得到5个变量的IV值。

![]()

因子型变量分箱

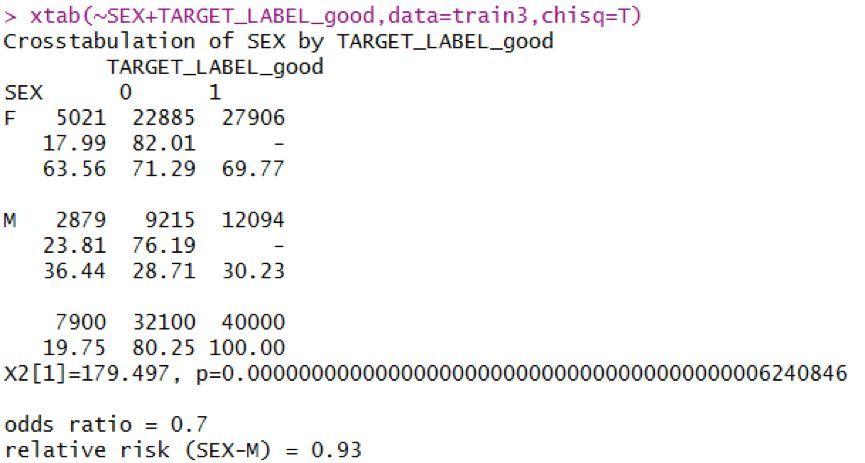

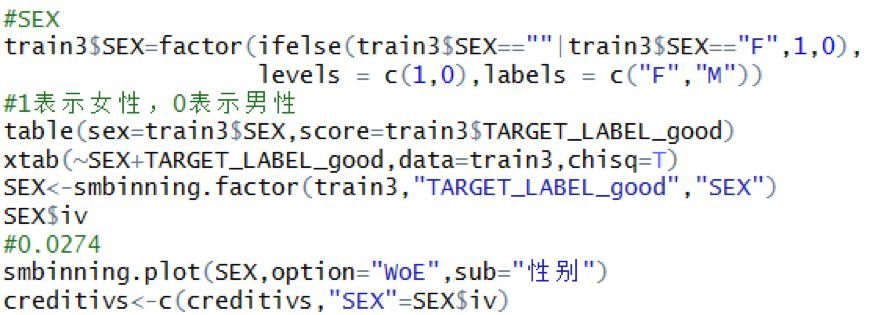

以性别分类变量举例说明,首先对性别变量中的异常值进行处理,这种类别变量一般将异常值归为多数这类。查看分布情况可知女性的守信情况似乎比男性好一些。性别变量的WOE值区分得也很明显。

在进行分箱之前同数值型变量一样,要检验两分布是否有显著性差别,由于因变量和自变量均为分类变量,故用卡方检验。原假设为两分布之间无显著性差别,卡方检验结果表明拒绝原假设,认为两样本有显著性差别,可以进行分箱。

分类变量分箱也采用的是smbinning包,不过smbinning包中就是用原分类值进行属性划分,未对划分属性处理,分类变量用的函数是smbinning.factor(),最后得到SEX的IV值为0.0274。具体执行代码如下:

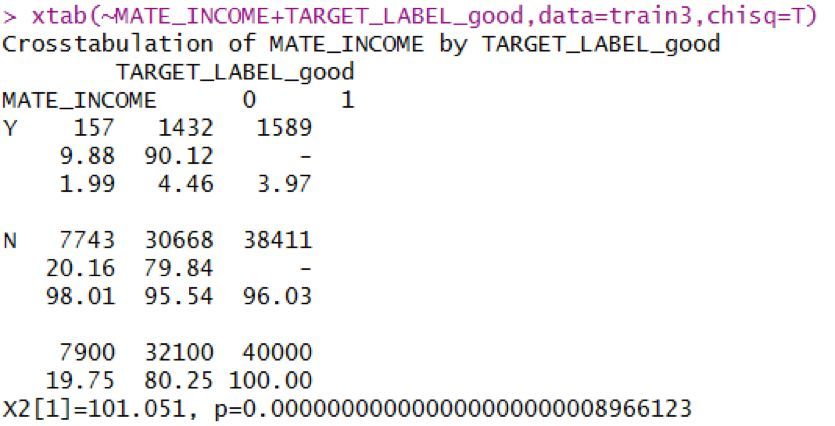

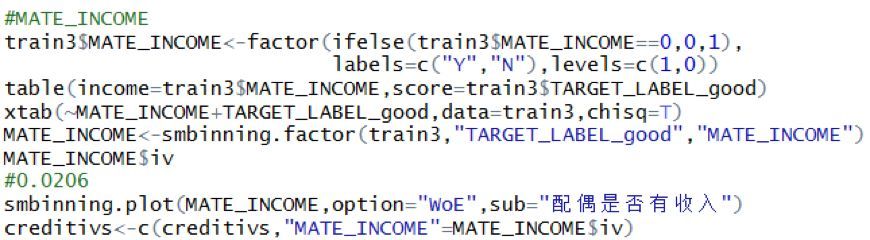

再以配偶收入举例说明,这个变量原本是数值型变量,由于取值过于集中到0,故将该变量转化为分类型变量再处理,处理方式是将取值为0的作为无收入,将取值大于0的作为有收入。

得到混淆矩阵可以看出,有收入的似乎比无收入的守信情况好一些,WOE图的区别也较为明显。

通过卡方检验也可以看出,是否有收入对信用好否有显著性影响,可以进行分箱操作。最后分箱得到IV值为0.0206。具体代码如下:

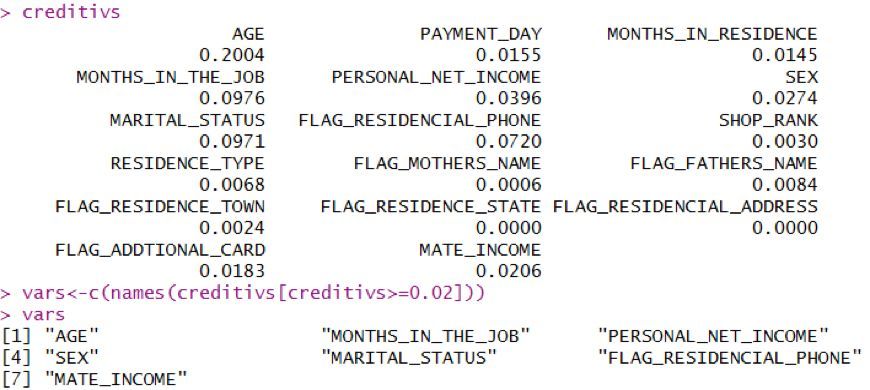

类推到其他因子型变量,计算出得到所有变量的IV值,存入creditivs中。

建立评分卡

得到所有可分箱变量的IV值,一般认为IV值大于等于0.02的对构建评分卡具有一定的帮助,故以0.02为分界点得到满足条件的变量。最后纳入评分卡模型的变量分别是年龄、工作时长(月)、个人收入、性别、婚姻状态、是否有自用手机、配偶是否有收入。

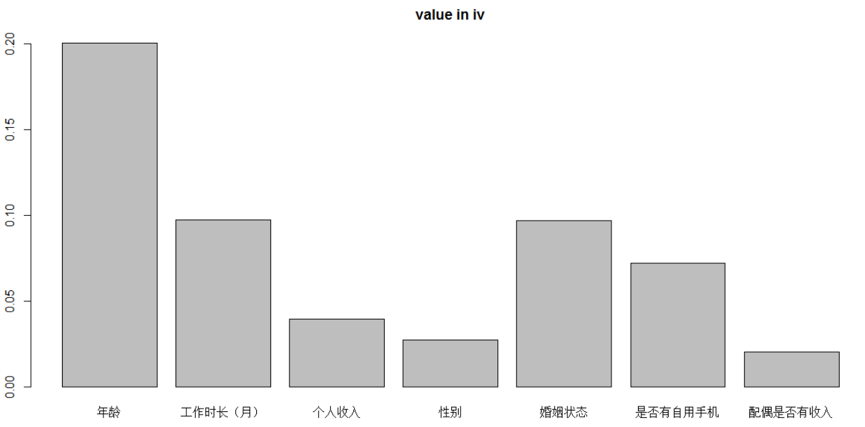

最后7个自变量的IV值的分布情况如下,可以看到年龄、婚姻状态、工作时长、是否有自用手机这几个变量的IV值较大,表明这几个变量对预测结果影响较大。

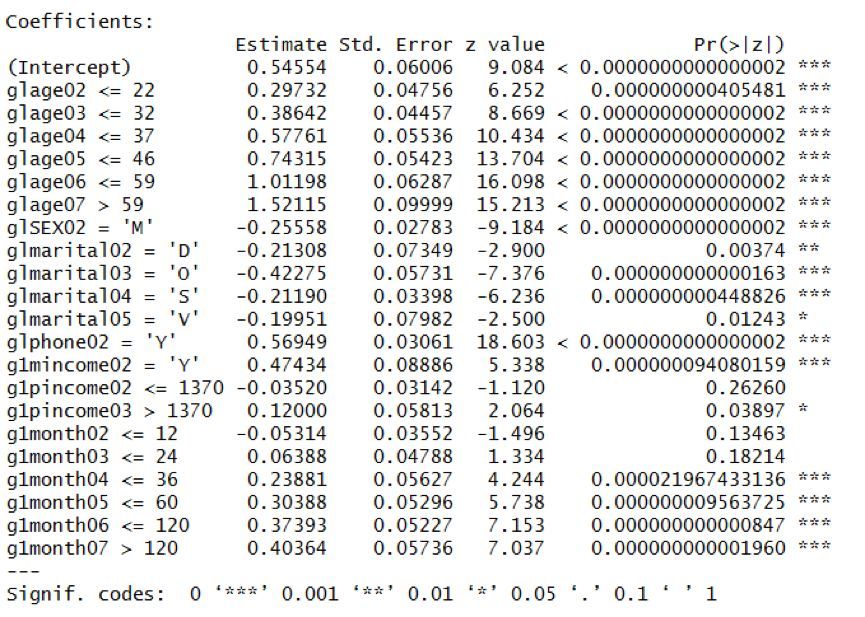

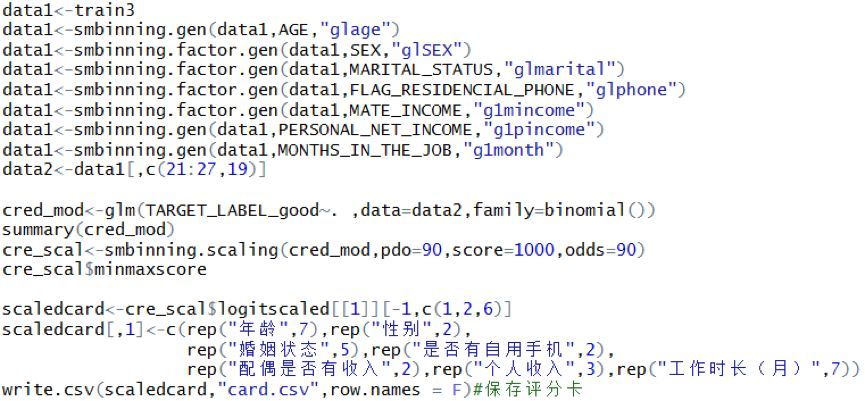

数值型分箱变量用函数smbinning.gen(),因子型变量用函数smbinning.factor.gen(),可以生成分箱后的结果,分箱后生成的新列并因变量得到data2数据集,通过逻辑回归,建立评分卡模型。通过逻辑回归结果可以看出分箱后的变量都较为显著,表示分箱结果优良。

生成评分卡是用函数smbinning.scaling(),通过调节pdo,score,odds三个参数,使得评分卡最大值与最小值位于一个较好的范围。这里评分卡的区间为(389,888)。

最后保存为新的csv文件,评分卡就做好了。具体代码如下:

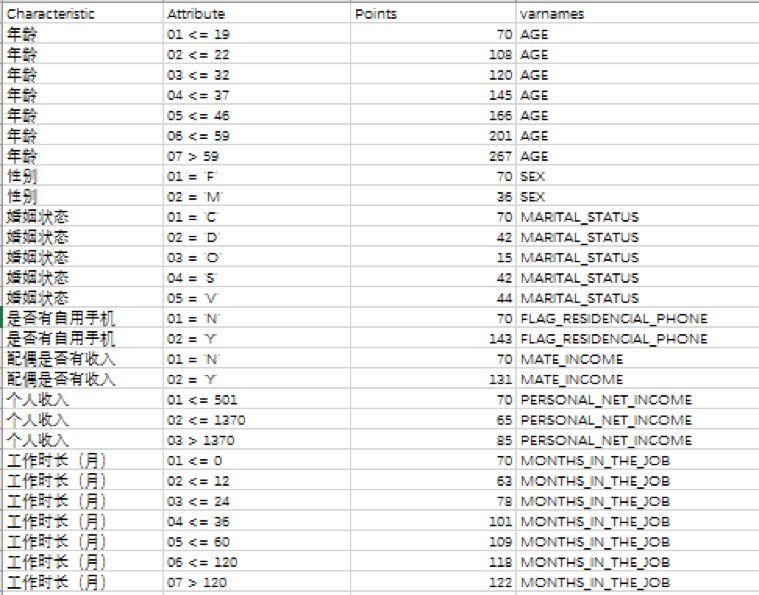

评分卡展示如下,points表示为评分卡的分值。如年龄在45岁的客户,得分为166分。

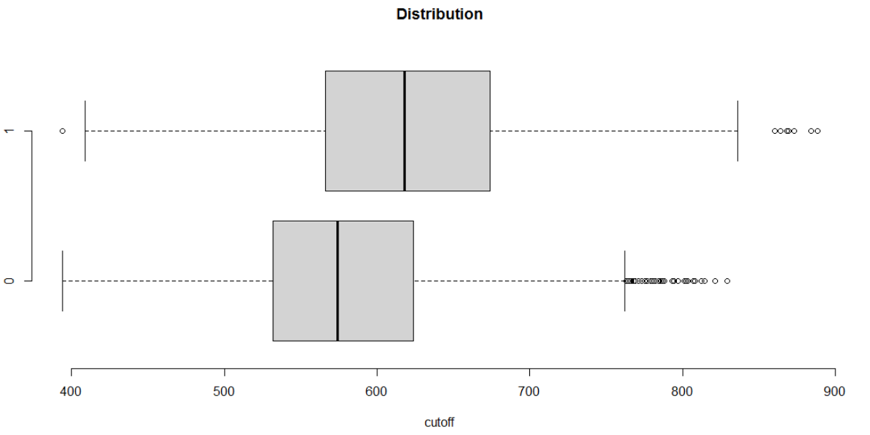

最后,你总得告诉领导或者同事,到底大于等于多少时,我们认为是好客户,这时还有最后一步,就是求cutoff值,将训练数据通过函数smbinning.scoring.gen()可以得到客户的得分,由于训练数据本身有是否违约这个变量,那么cutoff值有两种选择方式,第一种基于业务发展现状,即公司是需要盈利增收,还是公司需要控制风险,然后商议讨论选择一个cutoff值。下图为客户得分与客户违约的箱体图,1表示好客户,0表示坏客户,可以看出好客户的得分值会高于坏客户的得分值。

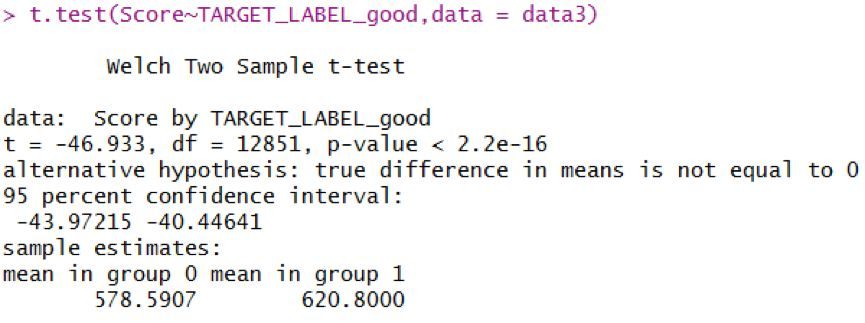

对客户得分与客户违约做t检验,检验结果表明,两分布具备显著性差别,可以认为好客户和坏客户的得分会有显著性差别。坏客户的得分集中在578分附近,好客户得分集中于620分附近。

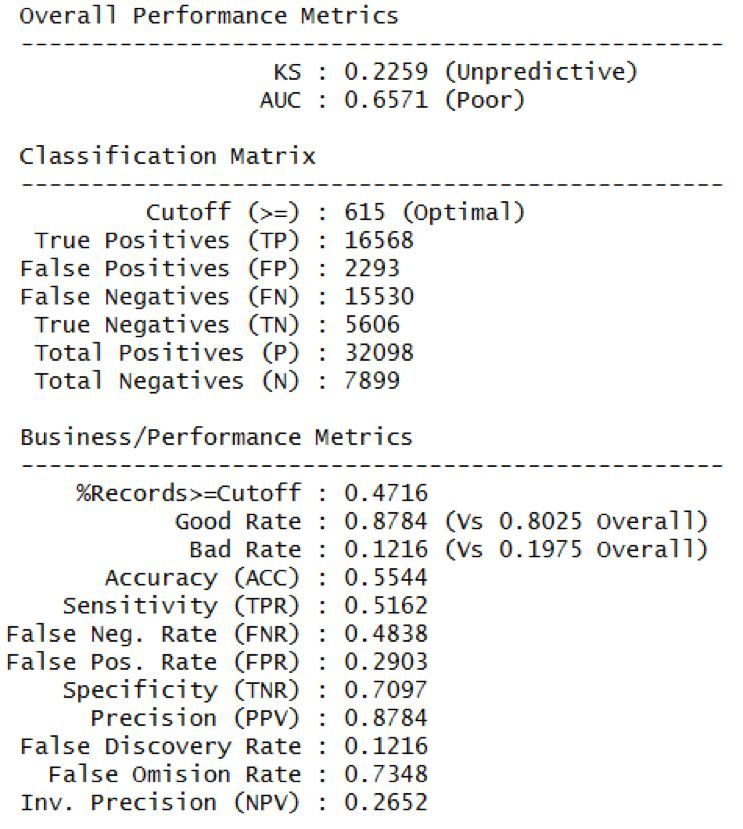

第二种获得cutoff值的方式就是电脑自动计算最优cutoff值,用的函数smbinning.metrics(),从输出的报告可以看出,最优cutoff值为615,这样划分的话,ROC曲线的AUC值为0.657,不算特别优良,准确率(precision)达到87.8%。

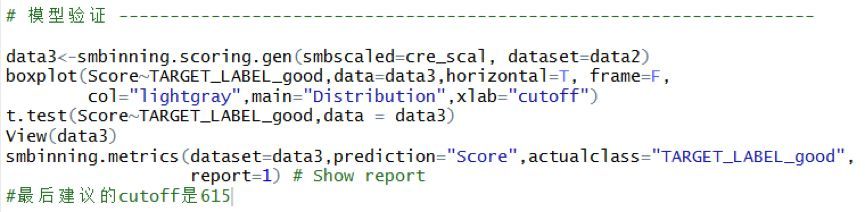

具体执行代码如下:

预测

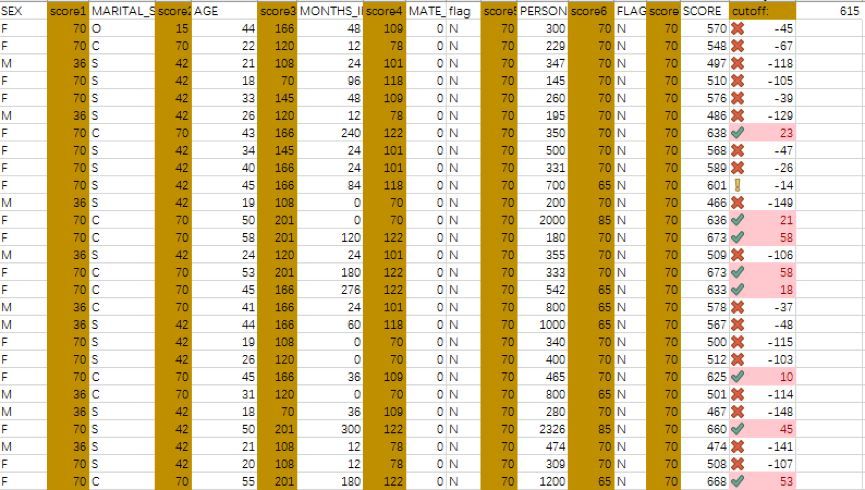

针对新样本,我选择用Excel工具获得信用评分,使用VLOOKUP函数可以很方便地得到想要的数据,评分展示如下,选择cutoff值为615,这里认为(600,620)的客户为关注客户,信用情况中等,620分以上的客户信用情况良好,600分以下的客户信用情况堪忧。

分别用!、√、×来表示中等、优良、较差的信用情况。

结语

本案例不足之处在于:

1. 未对职业代码、商店等级代码等信息进行提炼,可能会忽略掉一些有可能对模型有影响的变量。

2. Smbinning包在数值型变量分箱这一块很强大,但是对分类变量分箱结果不太尽如人意,可以考虑其他分箱方法。

3. 可以整合更多模型,从而提高预测准确率。

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

在当今数据驱动的时代,数据分析能力备受青睐,数据分析能力频繁出现在岗位需求的描述中,不分岗位的任职要求中,会特意标出“熟 ...

2025-04-03在当今数字化时代,数据分析师的重要性与日俱增。但许多人在踏上这条职业道路时,往往充满疑惑: 如何成为一名数据分析师?成为 ...

2025-04-02最近我发现一个绝招,用DeepSeek AI处理Excel数据简直太爽了!处理速度嘎嘎快! 平常一整天的表格处理工作,现在只要三步就能搞 ...

2025-04-01你是否被统计学复杂的理论和晦涩的公式劝退过?别担心,“山有木兮:统计学极简入门(Python)” 将为你一一化解这些难题。课程 ...

2025-03-31在电商、零售、甚至内容付费业务中,你真的了解你的客户吗? 有些客户下了一两次单就消失了,有些人每个月都回购,有些人曾经是 ...

2025-03-31在数字化浪潮中,数据驱动决策已成为企业发展的核心竞争力,数据分析人才的需求持续飙升。世界经济论坛发布的《未来就业报告》, ...

2025-03-28你有没有遇到过这样的情况?流量进来了,转化率却不高,辛辛苦苦拉来的用户,最后大部分都悄无声息地离开了,这时候漏斗分析就非 ...

2025-03-27TensorFlow Datasets(TFDS)是一个用于下载、管理和预处理机器学习数据集的库。它提供了易于使用的API,允许用户从现有集合中 ...

2025-03-26"不谋全局者,不足谋一域。"在数据驱动的商业时代,战略级数据分析能力已成为职场核心竞争力。《CDA二级教材:商业策略数据分析 ...

2025-03-26当你在某宝刷到【猜你喜欢】时,当抖音精准推来你的梦中情猫时,当美团外卖弹窗刚好是你想吃的火锅店…… 恭喜你,你正在被用户 ...

2025-03-26当面试官问起随机森林时,他到底在考察什么? ""请解释随机森林的原理""——这是数据分析岗位面试中的经典问题。但你可能不知道 ...

2025-03-25在数字化浪潮席卷的当下,数据俨然成为企业的命脉,贯穿于业务运作的各个环节。从线上到线下,从平台的交易数据,到门店的运营 ...

2025-03-25在互联网和移动应用领域,DAU(日活跃用户数)是一个耳熟能详的指标。无论是产品经理、运营,还是数据分析师,DAU都是衡量产品 ...

2025-03-24ABtest做的好,产品优化效果差不了!可见ABtest在评估优化策略的效果方面地位还是很高的,那么如何在业务中应用ABtest? 结合企业 ...

2025-03-21在企业数据分析中,指标体系是至关重要的工具。不仅帮助企业统一数据标准、提升数据质量,还能为业务决策提供有力支持。本文将围 ...

2025-03-20解锁数据分析师高薪密码,CDA 脱产就业班助你逆袭! 在数字化浪潮中,数据驱动决策已成为企业发展的核心竞争力,数据分析人才的 ...

2025-03-19在 MySQL 数据库中,查询一张表但是不包含某个字段可以通过以下两种方法实现:使用 SELECT 子句以明确指定想要的字段,或者使 ...

2025-03-17在当今数字化时代,数据成为企业发展的关键驱动力,而用户画像作为数据分析的重要成果,改变了企业理解用户、开展业务的方式。无 ...

2025-03-172025年是智能体(AI Agent)的元年,大模型和智能体的发展比较迅猛。感觉年初的deepseek刚火没多久,这几天Manus又成为媒体头条 ...

2025-03-14以下的文章内容来源于柯家媛老师的专栏,如果您想阅读专栏《小白必备的数据思维课》,点击下方链接 https://edu.cda.cn/goods/sh ...

2025-03-13