考虑一种棘手的情况:训练数据中大部分样本没有标签。此时,我们可以考虑使用半监督学习方法来处理。半监督学习能够利用这些额外的未标记数据,更好地捕捉数据分布的潜在形状,并在新样本上的泛化能力更强。当我们只有非常少量的已标记数据,同时有大量未标记数据点时,这种算法可以表现得非常出色。

在sklearn中,基于图算法的半监督学习有Label Propagation和Label Spreading两种。他们的主要区别是第二种方法带有正则化机制。

Label Propagation算法基于图理论。算法首先构建一个图,其中每个节点代表一个数据点,无论是标记的还是未标记的。节点之间的边代表数据点之间的相似性。算法的目的是通过图传播标签信息,使未标记数据获得标签。

相似性度量:通常使用K近邻(KNN)或者基于核的方法来定义数据点之间的相似性。

标签传播:标签信息从标记数据点传播到未标记数据点,通过迭代过程实现。

适用场景:适合于数据量较大、标记数据稀缺的情况。

Label Spreading和Label Propagation非常相似,但在处理标签信息和正则化方面有所不同。它同样基于构建图来传播标签。

正则化机制:Label Spreading引入了正则化参数,可以控制标签传播的过程,使算法更加健壮。

稳定性:由于正则化的存在,Label Spreading在面对噪声数据时通常比Label Propagation更稳定。

适用场景:同样适用于有大量未标记数据的情况,尤其当数据包含噪声时。

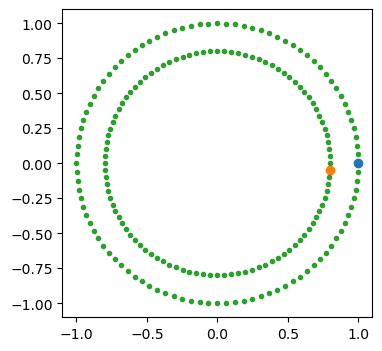

本文首先介绍Label Propagation,带有正则的Label Spreading 将在下篇介绍。首先生成一些凹的数据。

# 生成环形数据

import numpy as np

from sklearn.datasets import make_circles

X, y = make_circles(n_samples=200, shuffle=False)

outer, inner = 0, 1

labels = np.full(200, -1.0)

labels[0] = outer

labels[-1] = inner

# 画图

import matplotlib.pyplot as plt

plt.figure(figsize=(4, 4))

plt.scatter(X[labels == outer, 0], X[labels == outer, 1],)

plt.scatter(X[labels == inner, 0], X[labels == inner, 1],)

plt.scatter(X[labels == -1, 0], X[labels == -1, 1], marker=".",);

标签处理是CDA数据分析师二级考试的核心内容,在给工商银行等银行做内训时,这一部分技能是银行最重视的,因为银行防作弊放欺诈最核心的就是对用户打标签,如果大家想提升这块的能力,点击下方链接。

Label Propagation算法的迭代计算过程是基于图论原理的。在这个过程中,算法首先构建一个图,其中每个节点代表一个数据点,然后通过图中的连接来传播标签信息。下面是详细的步骤介绍:

首先,算法构建一个图,图中的每个节点代表一个数据样本。这些节点包括已标记的节点和未标记的节点。

在图中,节点之间的边代表数据点之间的相似性。这种相似性通常通过一些度量来计算,比如欧几里得距离(用于K近邻方法)或者基于核的相似性函数(如高斯核)。每条边的权重反映了两个节点之间的相似度。

对于每个数据点,算法维护一个标签分布向量。对于已标记的数据点,这个向量直接反映了其标签信息。对于未标记的数据点,标签分布初始通常是均匀的,或者用其他方式初始化。

接下来,算法进入迭代过程。在每次迭代中,每个未标记节点的标签信息会根据其邻居节点(包括已标记和未标记的节点)的标签信息进行更新。具体来说,一个节点的新标签分布是其所有邻居节点的标签分布的加权平均,权重由相似性权重决定。

更新完所有未标记节点的标签分布后,通常需要对这些分布进行归一化处理,以确保它们表示有效的概率分布。

这个过程会不断迭代,直到达到某个收敛条件,比如迭代次数达到预设的上限,或者标签分布的变化小于某个阈值。

一旦算法收敛,每个未标记数据点的标签被确定为其标签分布中概率最高的标签。

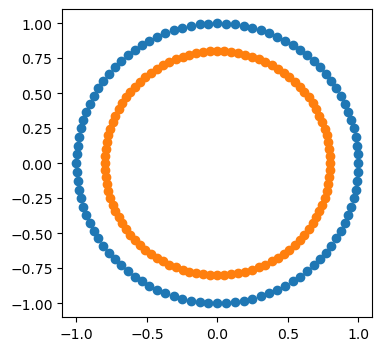

# Label Propagation

from sklearn.semi_supervised import LabelPropagation

label_propagation = LabelPropagation(kernel="knn")

label_propagation.fit(X, labels)

# Label Propagation打标签后的结果

output= np.asarray(label_propagation.transduction_)

outer_numbers = np.where(output == outer)[0]

inner_numbers = np.where(output == inner)[0]

plt.figure(figsize=(4, 4))

plt.scatter(X[outer_numbers, 0], X[outer_numbers, 1],)

plt.scatter(X[inner_numbers, 0], X[inner_numbers, 1],);

注意参数kernel="knn"。可以发现,若把kernel换成rbf,则无法得到正确传播结果。这是因为rbf是考虑全局的数据分布,因此内圈初始的标签扩散出去后很难被更新。KNN只考虑局部,不会出现此问题。

数据量大,计算资源有限。

数据点分布稀疏,且局部邻域信息足够区分标签(如聚类明显的情况下)。

数据量较小或中等,计算资源充足。

数据点分布紧密,且需要捕获全局信息(如图像或文本的复杂分布)。

随着各行各业进行数字化转型,数据分析能力已经成了职场的刚需能力,这也是这两年CDA数据分析师大火的原因。和领导提建议再说“我感觉”“我觉得”,自己都觉得心虚,如果说“数据分析发现……”,肯定更有说服力。想在职场精进一步还是要学习数据分析的,统计学、概率论、商业模型、SQL,Python还是要会一些,能让你工作效率提升不少。备考CDA数据分析师的过程就是个自我提升的过程。

CDA 考试官方报名入口:https://www.cdaglobal.com/pinggu.html

考虑一种棘手的情况:训练数据中大部分样本没有标签。此时,我们可以考虑使用半监督学习方法来处理。半监督学习能够利用这些额 ...

2025-02-04一、数学函数 1、取整 =INT(数字) 2、求余数 =MOD(除数,被除数) 3、四舍五入 =ROUND(数字,保留小数位数) 4、取绝对值 =AB ...

2025-02-03作者:CDA持证人 余治国 一般各平台出薪资报告,都会哀嚎遍野。举个例子,去年某招聘平台发布《中国女性职场现状调查报告》, ...

2025-02-02真正的数据分析大神是什么样的呢?有人认为他们能轻松驾驭各种分析工具,能够从海量数据中找到潜在关联,或者一眼识别报告中的数 ...

2025-02-01现今社会,“转行”似乎成无数职场人无法回避的话题。但行业就像座围城:外行人看光鲜,内行人看心酸。数据分析这个行业,近几年 ...

2025-01-31本人基本情况: 学校及专业:厦门大学经济学院应用统计 实习经历:快手数据分析、字节数据分析、百度数据分析 Offer情况:北京 ...

2025-01-3001专家简介 徐杨老师,CDA数据科学研究院教研副总监,主要负责CDA认证项目以及机器学习/人工智能类课程的研发与授课,负责过中 ...

2025-01-29持证人简介 郭畅,CDA数据分析师二级持证人,安徽大学毕业,目前就职于徽商银行总行大数据部,两年工作经验,主要参与两项跨部 ...

2025-01-282025年刚开启,知乎上就出现了一个热帖: 2024年突然出现的经济下行,使各行各业都感觉到压力山大。有人说,大环境越来越不好了 ...

2025-01-27在数据分析的世界里,“对比”是一种简单且有效的方法。这就像两个女孩子穿同一款式的衣服,效果不一样。 很多人都听过“货比三 ...

2025-01-26数据指标体系 “数据为王”相信大家都听说过。当前,数据信息不再仅仅是传递的媒介,它成为了驱动经济发展的新燃料。对于企业而 ...

2025-01-26在职场中,当你遇到问题的时候,如果感到无从下手,或者抓不到重点,可能是因为你掌握的思维模型不够多。 一个好用的思维模型, ...

2025-01-25俗话说的好“文不如表,表不如图”,图的信息传达效率很高,是数据汇报、数据展示的重要手段。好的数据展示不仅需要有图,还要选 ...

2025-01-24数据分析报告至关重要 一份高质量的数据分析报告不仅能够揭示数据背后的真相,还能为企业决策者提供有价值的洞察和建议。 年薪70 ...

2025-01-24又到一年年终时,各位打工人也迎来了展示成果的关键时刻 —— 年终述职。一份出色的年终述职报告,不仅能全面呈现你的工作价值, ...

2025-01-23“用户旅程分析”概念 用户旅程图又叫做用户体验地图,它是用于描述用户在与产品或服务互动的过程中所经历的各个阶段、触点和情 ...

2025-01-22在竞争激烈的商业世界中,竞品分析对于企业的发展至关重要。今天,我们就来详细聊聊数据分析师写竞品分析的那些事儿。 一、明确 ...

2025-01-22在数据分析领域,Excel作为一种普及率极高且功能强大的工具,无疑为无数专业人士提供了便捷的解决方案。尽管Excel自带了丰富的功 ...

2025-01-17在这个瞬息万变的时代,许多人都在寻找能让他们脱颖而出的职业。而数据分析师,作为大数据和人工智能时代的热门职业,自然吸引了 ...

2025-01-14Python作为一门功能强大的编程语言,已经成为数据分析和可视化领域的重要工具。无论你是数据分析的新手,还是经验丰富的专业人士 ...

2025-01-10